この記事は10分で読むことができます。

注目のポイント

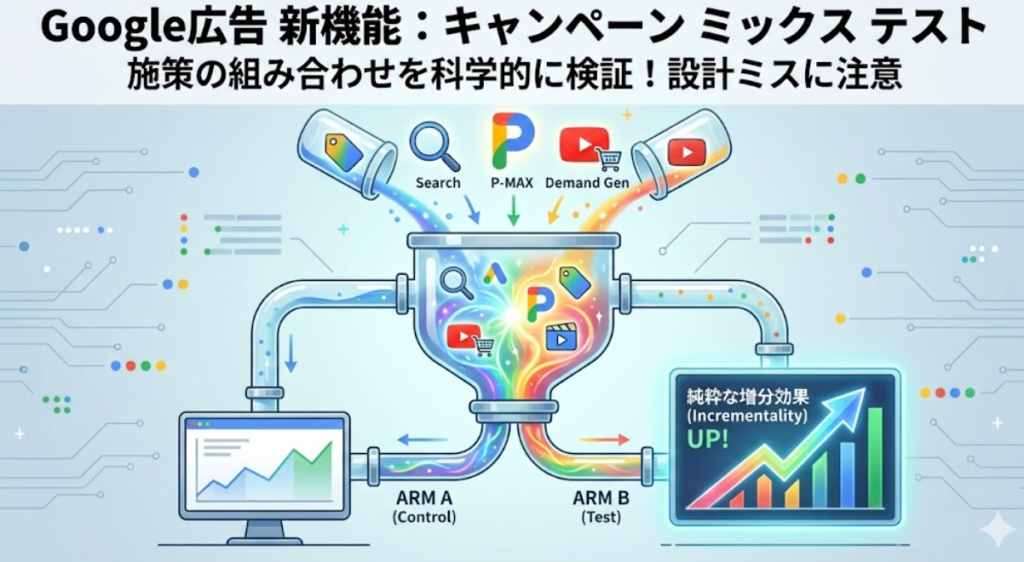

Google広告の新機能「キャンペーン ミックス テスト」を使えば、Power Pack(検索+P-MAX+Demand Gen)のような複数キャンペーンの組み合わせ効果を検証できます。

しかし、ARMは「箱」でしかなく、入札目標やコンバージョン設定はキャンペーン単位で行います。ARM内で目標値がバラバラだと、AIの最適化が偏り「効果なし」という誤った結論に至ります。

正しく検証するには、全キャンペーンで入札目標とコンバージョンアクションを統一すること。ポートフォリオ入札戦略の活用も推奨されます。設計ミスは致命的ですが、正しく設計すれば増分効果を正確に測定できます。

この記事はVoicy「Google広告の「AI MAX」の攻略と「キャンペーンミックステスト」でPower PackのABテストが!?【石黒堂】」で聴くことができます

目次

Google広告に新機能「キャンペーン ミックス テスト」が登場

Google広告に、新たなテスト機能「キャンペーン ミックス テスト(Campaign Mix Experiments)」のベータ版が実装されました。

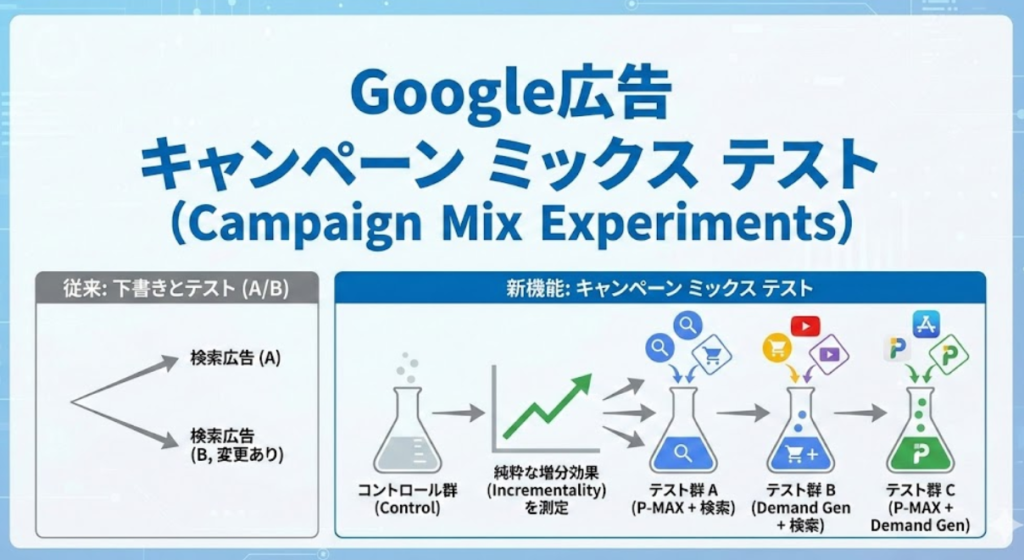

従来、Google広告でA/Bテストを行う際は「下書きとテスト」という機能を使うのが一般的でした。これは1つのキャンペーンに対して設定変更を加えたバージョンを作り、元のキャンペーンと比較検証するものです。

しかし、この方法には限界がありました。複数のキャンペーンタイプを組み合わせた施策の効果を検証できないという点です。

例えば、こんな疑問に答えることができませんでした。

「今は検索広告だけで運用しているが、ここにP-MAXとDemand Genを追加したら、本当にコンバージョンが純増するのか?ROIは維持できるのか?」

キャンペーン ミックス テストは、まさにこの課題を解決するために生まれた機能です。

何ができるのか?

- 検索、P-MAX、ショッピング、Demand Gen、動画、アプリなど、異なるキャンペーンタイプを組み合わせてテストできる

- 最大5つのグループ(ARM)を作成し、同時比較が可能

- トラフィックを分割して、純粋な増分効果(Incrementality)を測定できる

この機能により、「施策の組み合わせ」そのものを科学的に検証できるようになりました。

ただし、この機能は非常に強力である反面、設計を間違えると誤った結論を導いてしまう危険性も秘めています。

参照:About Campaign Mix Experiments (Beta) – Google Ads Help

テストの仕組み:「ARM」という概念を理解する

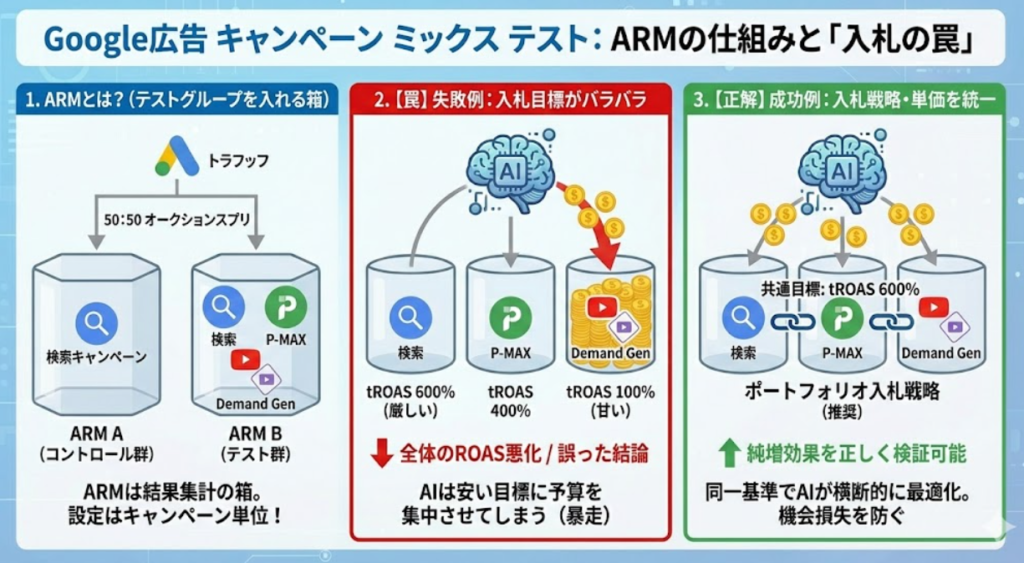

キャンペーン ミックス テストを理解する上で、最も重要なのが「ARM(アーム)」という概念です。

ARMとは何か?

一言で言えば、「テストグループを入れる箱」です。従来のA/Bテストで言うところの「パターンA」「パターンB」に相当するものだと考えてください。

例えば、こんな検証をしたいとします。

- ARM A(コントロール群):検索キャンペーンのみ

- ARM B(テスト群):検索+P-MAX+Demand Genの3キャンペーン

この場合、ARM Aには検索キャンペーン1つを入れ、ARM Bには3つのキャンペーンを入れることになります。

トラフィック分割の仕組み

ここで重要なのが、トラフィック分割は「予算」ではなく「オークション」単位で行われるという点です。仮に50:50で分割した場合はこうなります。

- ARM Aに割り当てられたオークションには、検索広告のみが表示される

- ARM Bに割り当てられたオークションには、検索・P-MAX・Demand Genの3つすべてが表示される可能性がある

つまり、オークションは半々に分かれますが、ARM Bの方が配信面(在庫)の選択肢が多いため、オークションに参加できる機会が多く、結果として表示回数が増える可能性が高いです。

そして、ここが最大のポイントなのですが、ARMはあくまで「結果を集計するための箱」でしかありません。

ARMレベルで設定できること

- どのキャンペーンを含めるか

- トラフィック分割の比率(50:50、30:70など)

ARMレベルで設定できないこと

- 入札目標(tROAS、tCPAなど)

- コンバージョンアクション

- 予算設定

「入札目標」「コンバージョンアクション」「予算設定」は、キャンペーン単位での設定が適用されます。この仕様を理解していないと、次に説明する「罠」に確実にハマることになります。

【罠】ARMは箱、入札設定はキャンペーン単位という落とし穴

ここからが本題です。キャンペーン ミックス テストで最も陥りやすい、そして最も危険な罠について解説します。前述の通り、ARMはキャンペーンをグルーピングして結果を集計するための箱です。ARMレベルでは、入札目標やコンバージョン設定は一切できません。すべての設定はキャンペーン単位で行う必要があります。

よくある失敗例

現在、検索キャンペーンでtROAS 600%で運用しているとします。ここにP-MAXとDemand Genを追加してテストしたい場合、こんな設定にしてしまうケースがあります。

- ARM A:検索キャンペーン(tROAS 600%)

- ARM B:

- 検索キャンペーン(tROAS 600%)

- P-MAXキャンペーン(tROAS 400%)

- Demand Genキャンペーン(tROAS 100%)← 甘い設定

「とりあえず配信させてみよう」という意図で、Demand Genの目標を甘く設定してしまうパターンです。この場合にスマート自動入札のAIは、設定された目標を達成することに最適化されます。

- tROAS 600%の検索・P-MAX:目標達成が厳しい→予算が抑制される

- tROAS 100%のDemand Gen:目標達成が容易→予算が優先的に配分される

結果として、ARM B全体のROASは悪化します。そして「キャンペーンミックステストを試したけど、ROIが下がった。やっぱり効果ないじゃないか」という誤った結論に至ってしまいます。

本来検証すべきなのは、「同じROI水準で、コンバージョン数が純増するか」という点です。入札目標がバラバラでは、この検証ができません。「ARMごとにKPIを設定できるわけではなく、あくまでキャンペーン単位の設定が適用される」この仕様を理解していないと、テスト設計そのものが破綻してしまいます。

正しい検証設計:入札戦略と単価を統一せよ

では、どうすれば正しくテストできるのでしょうか。重要なのは、ARM AとARM B内の全キャンペーンで入札目標を統一することです。

- ARM A:検索キャンペーン(tROAS 600%)

- ARM B:

- 検索キャンペーン(tROAS 600%)

- P-MAXキャンペーン(tROAS 600%)

- Demand Genキャンペーン(tROAS 600%)

※すべて同じ目標値に設定

スマート自動入札の単価を統一する

スマート自動入札入札戦略を使うことで、AIは「ARM B全体でtROAS 600%を達成する」という統一された目標に向けて最適化を行います。

- どのキャンペーンに予算を配分すべきかをAIが横断的に判断できる

- 特定のキャンペーンに予算が偏る「暴走」を防げる

- 検索やP-MAXの機会損失を防ぎながら、Demand Genの効果も適切に評価できる

コンバージョンアクションを統一する

入札目標だけでなく、コンバージョンアクションも統一することが重要です。

- 検索:「資料請求」をカウント

- Demand Gen:「資料請求」+「ページビュー」をカウント

このように計測対象が異なると、やはりAIの最適化がブレてしまいます。全キャンペーンで同じコンバージョンアクション(例:資料請求のみ)を設定することで、初めて「同じ成果指標で比較する」という条件が整います。

Googleの推奨事項にも明記されている

実は、この点についてはGoogleの公式ヘルプでも言及されています。

Campaigns in an arm should be either individual campaigns or part of the same portfolio bid strategy.

ARM内のキャンペーンは「個別キャンペーンとして独立させるか、同じポートフォリオ入札戦略でまとめるか」のどちらかにすべきだと明示されています。個別でスマート自動入札の設定をしない場合は、キャンペーンを跨いで設定ができるポートフォリオ入札戦略がおすすめです。

参照:About Campaign Mix Experiments (Beta) – Google Ads Help

推奨テスト:Power Pack(検索広告+P-MAX+Demand Gen)で増分効果を検証

正しい検証設計の方法を理解したところで、では具体的に何をテストすべきなのでしょうか。私はPower Packの実施検証をオススメします。

Power Packとは!?

Googleが推奨している「Power Pack」とは、検索・P-MAX・Demand Genの3つのキャンペーンタイプを組み合わせた施策パッケージのことです。

Power Packのそれぞれの広告の役割

- 検索広告:スマート自動入札×インテントマッチを活用し、関連クエリでのコンバージョンを最大化

- P-MAX:最新のAIテクノロジーで検索広告を補完しつつ、他の配信面でコンバージョンを最大化

- Demand Gen:没入感の高いビジュアル重視のクリエイティブで、消費者をコンバージョンに導く

これら3つを掛け合わせることで、AIによるネットワーク横断での相互学習が強化され、広告の成果を飛躍的に向上させることが期待されています。

Googleが公表している効果データ

- Power Pack全体:ROIを維持しながら平均+18%のCV数増加を実現

- 検索広告の最適化(AI最大化設定×スマート自動入札×インテントマッチ):ROIを維持しながら**+20%のCV数増加、+19%のCV値増加**

- 検索またはP-MAXにDemand Genを追加:平均+14%のCV数増加

もしARM BのROASがARM Aと同等で、コンバージョン数が+15〜20%増加していれば、Power Packの効果が実証されたことになります。

※本データはGoogle提供資料より(掲載許可取得済み)

まとめ:機能は優秀、設計ミスは致命的

キャンペーン ミックス テストは、複数のキャンペーンタイプを組み合わせた施策の効果を科学的に検証できる強力な機能です。

しかし、ARMはあくまで「箱」であり、入札目標やコンバージョン設定はすべてキャンペーン単位で行う必要があります。この仕様を理解せずにテストを始めると、誤った結論を導いてしまう危険性があります。

正しく検証するために

- ARM内の全キャンペーンで入札目標を統一する

- コンバージョンアクションを統一する

- ポートフォリオ入札戦略の活用を検討する

- 最低6〜8週間のテスト期間を確保する

設計さえ正しく行えば、Power Packのような施策の増分効果を正確に測定できます。この記事で解説した注意点を押さえて、ぜひ自社アカウントでの検証に挑戦してみてください。

Web業界にて20年以上、大手から中堅代理店の顧問を請負。デジタルマーケティングを中心に、主に広告関係の教育や研修、コンペの相談に乗っています。またSEMのお役立ちツールもスクラッチで開発。現在も電通グループの顧問、Shirofuneのアルゴリズム作成補助など担当しており、年間100名以上を教育。皆さまに心から信頼されるパートナーであり続けるために日々研鑽しております。また、世界的権威のある One Voice Awards USA 2025 にも日本人としてノミネートされ、世界的なナレーターとしても活躍中です。